Les chatbots propagent globalement 35% de fake news. Deux fois plus que l’an passé

Déployés massivement dans les parcours clients, les chatbots déçoivent, sauf lorsqu’ils sont bien conçus, entraînés et soutenus par des vrais experts, disponibles.

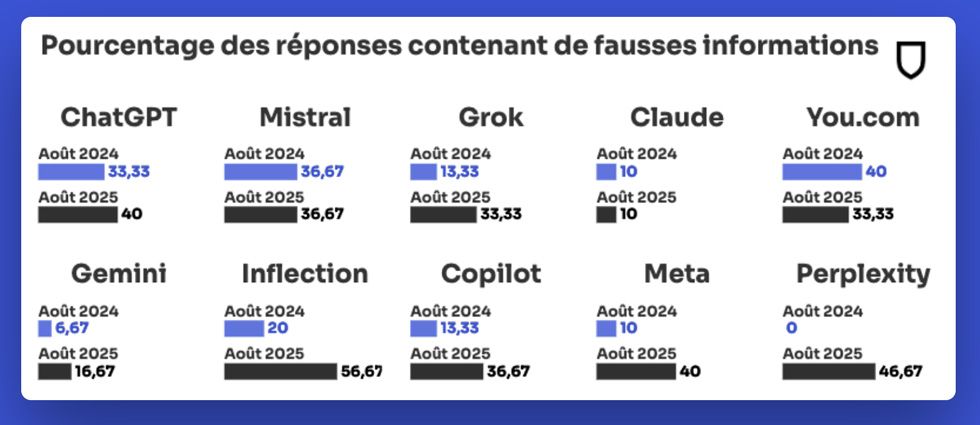

Claude (Anthropic) est le bon élève de la classe, Perplexity et Inflection les cancres. Tel est, en très résumé le classement de la fiabilité des chatbots fonctionnant avec les grands moteurs d'IA du marché.

Déployés dans les services clients, ils n’ont pas fait la preuve de leur efficacité. Leonard, celui de Chronopost est en cours de perfectionnement. Mais, chez Ista, qui déploie des compteurs connectés, l'IA aide les agents du call-center, internalisé, à répondre plus vite et mieux, aux appels et aux courriels.

Si l’on croit l’étude de NewsGuard publiée jeudi 4 septembre, le taux de désinformation propagée par les chatbots a doublé en un an, atteignant 35 %. Malgré les annonces sur leur performance et efficacité accrues, les outils d'IA peinent à distinguer le vrai du faux. Massivement déployés dans les services clients, ils contribuent à une merdification de l’expérience client, la enshittification évoquée par Cory Doctorow dans son livre, à paraître prochainement.

Les modèles d'IA sont de plus en plus puissants, affichent des fonctionnalités toujours plus nombreuses et les valorisations des acteurs de l'IA font qu’on parle désormais de décacorne, comme pour Mistral AI. « Pourtant, les ChatGPT, Perplexity, Le Chat, etc. n'arrivent toujours pas à distinguer le vrai du faux. Pis encore, le taux de fausses informations répétées par les grands chatbots a doublé en un an, selon une étude de NewsGuard.

Les dix plus gros outils d'IA analysés ont répété des informations erronées sur des sujets d'actualité dans plus d'un tiers des cas (35 %), en août 2025, contre 18 % à la même période l'an dernier. Pour le plus connu, ChatGPT, c'est même 40 %, assure la start-up spécialisée dans la lutte contre la désinformation. Malgré des annonces d'amélioration et des contrats avec la presse, les infox sont donc encore légion » (Source Les Echos)

Est-ce grave docteur ?

Oui, si l’on considère par exemple que de nombreuses personnes et citoyens dont les jeunes s’informent désormais massivement en interrogeant des IA.

Oui si l’on considère que dans certaines industries ou activités, les chatbots sont utilisés au cours des parcours clients. Chez Chronopost, comme nous l’avons détaillé, une demande de remboursement d’un colis perdu est traitée non plus par un agent de call-center mais par un chatbot et celui-ci répond des choses erronées, sur un cas complexe, au lieu de transférer la conversation. Chez Francoise Saget, un vépéciste cousin d’Atlas For Men, une question sur le redressement judiciaire de l’entreprise renvoie à une offre produit.

Oui, si ces annonces impactent les cours de Bourse, comme la fameuse étude Klarna. Plus grave, des acteurs malveillants exploitent ces failles en polluant le Web de faux sites Internet, de publications sur les réseaux sociaux, de « fermes » de contenus générées par IA.

Comment expliquer cette efficacité disparate ?

Les chatbots s’informent sur le web, veulent répondre à tout prix et ne pondèrent pas souvent les sources fiables. Plusieurs facteurs se combinent : comme un cancre que son professeur questionnerait un jour d’interrogation surprise, les chatbots veulent répondre à tout prix. Les « robots » n'hésitent pas à puiser leurs réponses dans des sources peu fiables. Le taux de non-réponse est ainsi passé de 31 % en août 2024 à 0 % cet été !

« L'an dernier encore, les politiques internes des acteurs de l'IA faisaient que beaucoup de chatbots évitaient des sujets sensibles où les versions grand public n'étaient pas reliées à Internet. Ils indiquaient donc qu'ils ne pouvaient pas répondre. Mais aujourd'hui, ils ont perdu cette prudence. Ils puisent dans les réponses disponibles, même si elles sont erronées », a expliqué Chine Labbé, rédactrice en chef de NewsGuard.

« Chaque modèle est entraîné avec un grand corpus, typiquement collecté sur le Web. Ce que chaque entreprise choisit de récolter est un peu « sa sauce secrète ». Eliminer les mauvaises données est très difficile ou impossible, car la collecte peut être vue comme « de la pêche au chalut » explique Ioana Manolescu-Goujot, chercheuse à l'Inria. « Les modèles répondent sur ce qui est le plus probable, si l'entreprise d'IA n'a pas configuré le modèle pour pondérer davantage les médias fiables, les contrats passés avec la presse n'ont que peu d'incidence. » ( Source : Les Echos)

Le « pire » est Inflection AI avec presque 57 % de réponses comportant des fausses informations. Perplexity est juste derrière avec presque 47 %, après avoir été le « bon élève » de l'été dernier. Les chatbots les plus « connus » comme ceux de Meta, OpenAI et Microsoft sont autour de 40 %. Le français Mistral est à 37 %.

Gemini (Google) et Claude (Anthropic) se distinguent avec des taux respectifs de 17 % et 10 %.

Deux bonnes nouvelles cependant

Les chatbots pointent de plus en plus des affirmations fausses. Le taux de réfutation (c'est-à-dire la capacité à dire qu'une information est fausse) a augmenté de 51 % à 65 % sur un an.

Dans certaines entreprises, on n’a pas utilisé l’AI pour mettre en place des chatbots qui font tout et répondent aux clients. On l’utilise au contraire afin de préparer les réponses qui seront données et validées par les agents. C’est par exemple le cas chez Ista, une société allemande, installée en France, qui déploie des compteurs individuels chez les particuliers, les gestionnaires (bailleurs sociaux et syndics) pour favoriser la maitrise des consommations d'eau et de chauffage. Ils ont permis de gagner 30 secondes par conversation menée avec un client, ce qui désengorge le service client et permet de répondre à plus d’e-mails, sans erreur. “Nous avons gagné en efficacité” indique Antoine Prioux, directeur de la transformation.

Comete. ai, fondée par des experts aguerris des call-centers et de la tech, s'est fait une spécialité du déploiement des technologies d'IA dont ces chatbots. Frédéric Donati, son CEO, a une conviction chevillée au corps : “utiliser l'IA dans les parcours clients n'est plus une question, une option. Elle est désormais efficace et peu chère. C'est dans la planification de son déploiement que tout se joue”

Chez un grand fabricant de chaudières, son équipe a récemment amélioré grandement le traitement des demandes d'intervention et leur planification, tout comme dans une grosse ETI spécialisée dans le facilities management, AGS Facilities. Chez l'un des leaders mondiaux du travail temporaire, même écho positif.

"C'est comme vous faites votre check-up à cinquante ans, sourit l'ingénieur de formation. Radios et passages par les éventuels spécialistes sont absolument nécessaires. Et suivi de la prescription ensuite. Sauter une de ces étapes est la meilleure façon de se planter"

(1) NewsGuard a testé en anglais les principaux chatbots sur un ensemble de fausses informations, avec des questions provenant de trois utilisateurs fictifs : l'un « innocent » qui n'avait aucun a priori en recherchant des informations ; l'un « orienté » qui part du principe que l'infox est vraie ; et enfin un utilisateur « malveillant » voulant propager de la désinformation.